AI(人工智能)服务器使用的GPU架构比CPU更适合大型并行计算机。通用服务器使用CPU作为计算能力的来源,但人工智能服务器使用CPU GPU异构服务器,这些服务器可以基于CPU和其他加速器等应用程序执行不同的组合。GPU主要用于提供计算功能,从ChatGPT模型计算方法的角度来看,使用并行计算机是其主要特点。与上一代RNN深度学习模型相比,Transformer架构中的AI模型通过为输入序列中的每个字符提供上下文,允许它同时处理所有输入,而不是一次只处理一个单词,可以更大规模地计算参数。从GPU计算方法的角度来看,GPU使用了许多计算单元和长管道,使其比CPU更适合于高通量AI并行计算。

深度学习主要涉及矩阵和向量计算,AI(人工智能)服务器的处理效率更高。从ChatGPT模型的结构来看,基于transformer结构,ChatGPT模式使用注意力机制来分配文本单词的权重,并使用反馈神经网络来输出数值结果。这个过程涉及大量的向量和张量,需要计算。人工智能服务器通常集成多个人工智能GPU,而人工智能GPU通常是折叠的,以加速深度学习算法的操作,支持多矩阵操作,如池化和激活功能。因此,人工智能场景中的人工智能服务器往往比GPU服务器具有更高的计算效率,并具有一定的应用优势。

主要的人工智能服务器计算芯片是GPU。根据IDC的数据,2022年国内人工智能芯片市场,GPU芯片占据了89.0%的主要市场份额。主要原因是GPU芯片并行计算架构更适合复杂的数学计算场景,能够更好地支持强大的并行工作负载。因此,数据广泛用于中心模型训练以及边缘和终端推理工作负载。此外,其他重要的人工智能芯片包括NPU、ASIC、FPGA等。

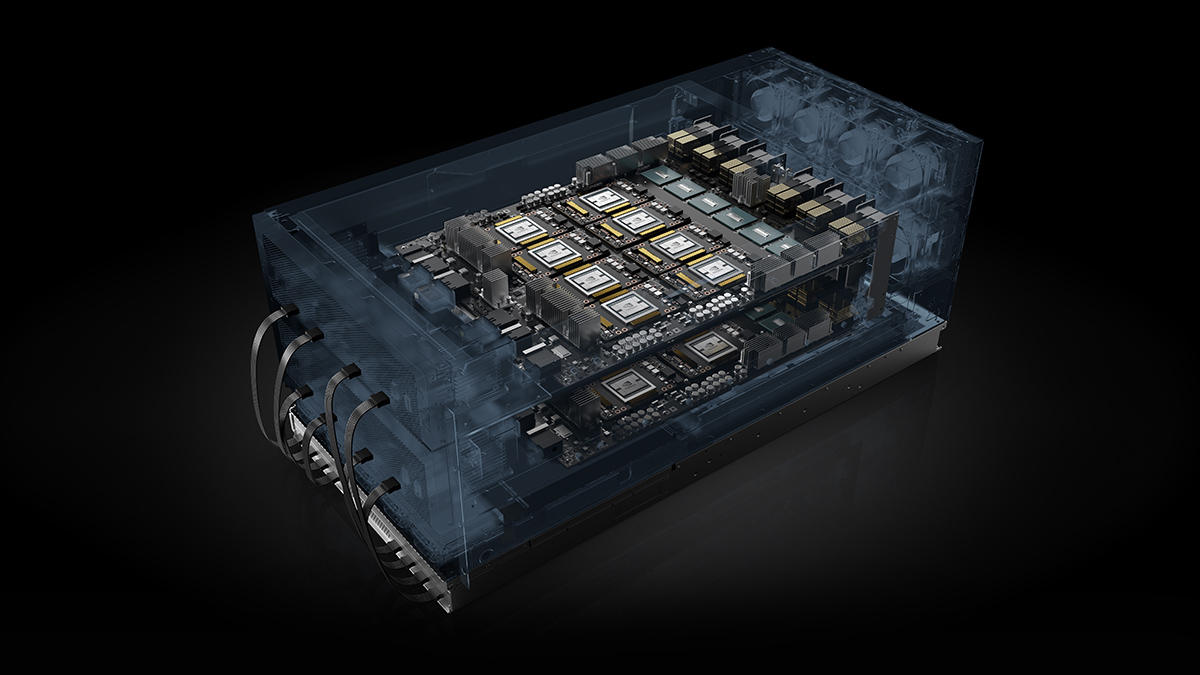

通常,AI(人工智能)服务器所需的计算芯片数量取决于服务器设计的性能要求,需求类型取决于成本、功耗和算法等指标。常见的计算芯片组合包括8个GPU+2个CPU、4个GPU+2x个CPU、8个FPGA+1x个CPU和4个FPGA+1个CPU等等。